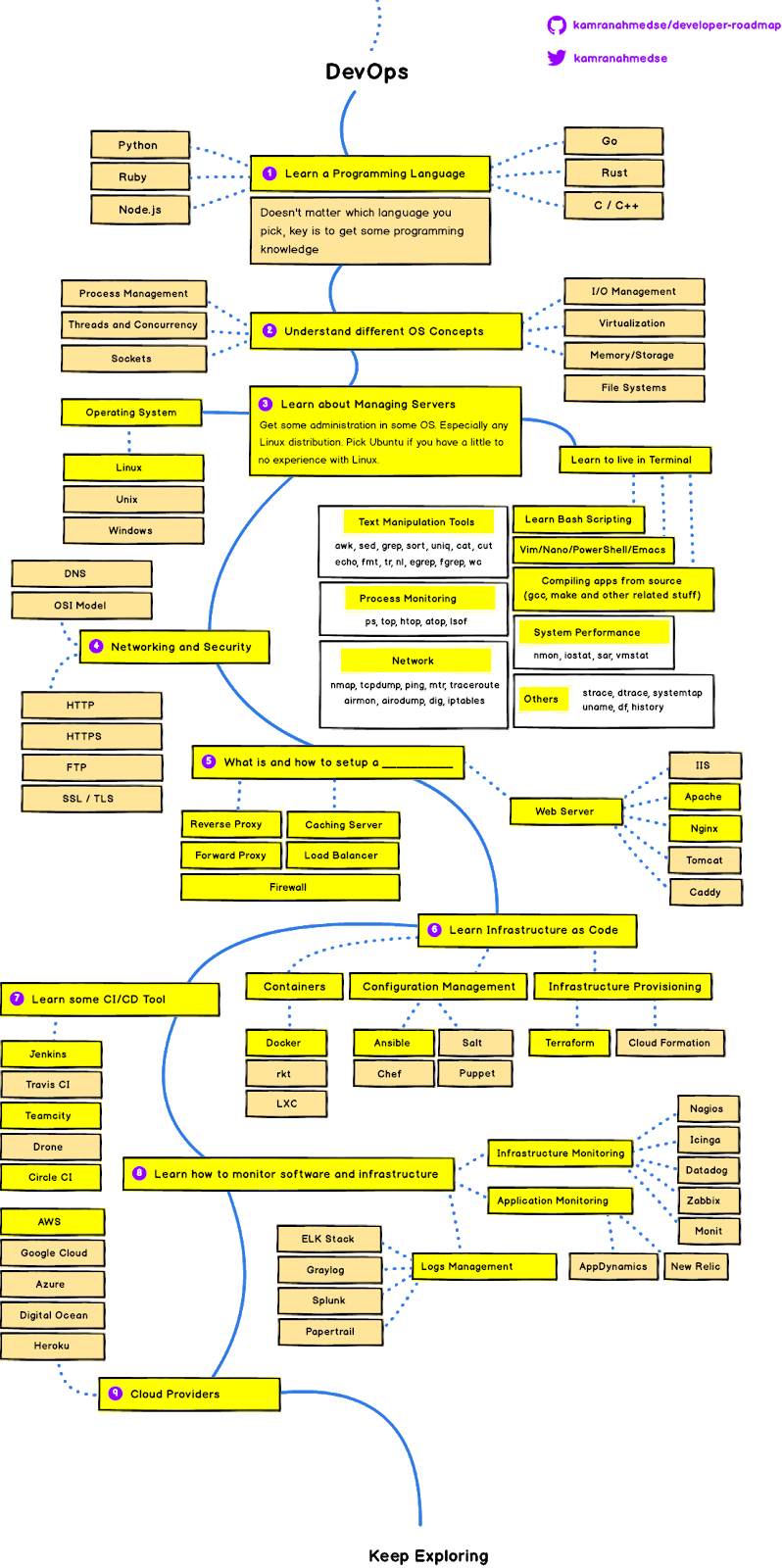

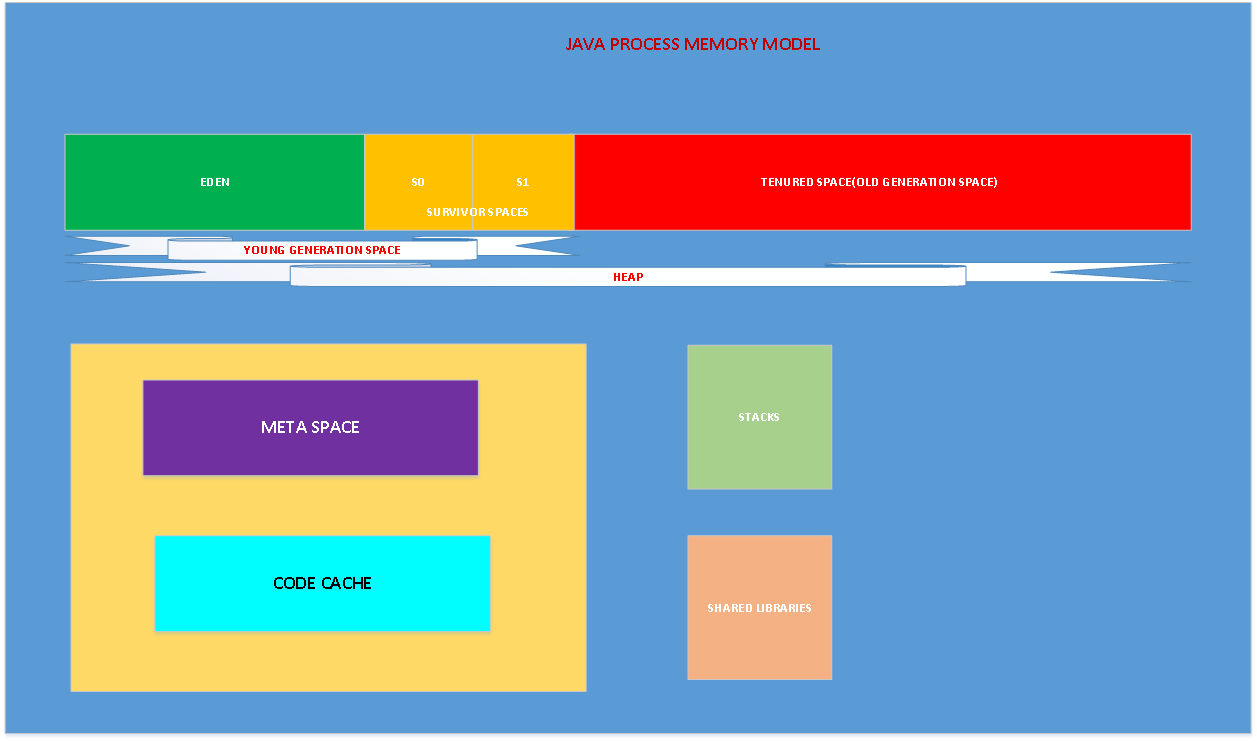

Trong bài viết này, kiến thức được áp dụng cho java 8 JDK8 Oracle Hot Spot 64 bit JVM. Trước hết, dưới đây là mô tả các vùng bộ nhớ của java

Mỗi khi khởi tạo JVM, OS cấp phát bộ nhớ cho process. Process cho chính con JVM, và phần bộ nhớ cấp cho nó bao gồm: Heap, meta space, JIT code cache, thread stack, và shared library. Chúng ta gọi phần bộ nhớ này là Native memory. Native memory là phần bộ nhớ được cung cấp cho các tiến trình bởi OS. Phần bộ nhớ này là bao nhiêu thì còn phụ thuộc vào OS, CPU, và JRE. Chúng ta cùng tìm hiểu qua về các phần bộ nhớ có trong JVM:

Heap Memory: JVM sử dụng phần bộ nhớ này để lưu trữ các object. Phần bộ nhớ này được chia ra làm 2 vùng khác nhau gọi là “Young Generation Space” và “Tenured Space“.

Young generation: hay còn gọi là New Space được chia thành 2 phần nhỏ hơn gọi là Eden Space” và “Survivor Space“.

Eden Space: khi chúng ta khởi tạo 1 object, phần bộ nhớ cho object đó sẽ lấy từ eden space.

Survivor space: chứa những object còn sót lại sau khi Young garbage collection hoặc Minor garbage collection hoạt động (2 trình dọn rác). Phần này được chia là 2 khối bộ nhớ bằng nhau: S0 và S1

Tenured space: object sẽ chạm ngưỡng tenused tối đa trong quá trình minor GC hoặc Young GC sẽ được move tới vùng này, hoặc vùng old generation space

Dưới đây, chúng ta sẽ nói thêm về garbage collection sau.

Meta space: Phần bộ nhớ này nằm bên ngoài của Heap memory, và cũng là 1 phần của native memory. theo tài liệu mặc định, meta space không có giới hạn max cụ thể là bao nhiêu. Trong các phiên bản java trước, phần bộ nhớ này được gọi là perm gen space. Phần bộ nhớ này có nhiệm vụ lưu trữ các định nghĩa các class bởi class loader. Nó được thiết kế để tránh lỗi out of memory. Tuy nhiên, nếu nó tăng tưởng vượt quá dung lượng có sẵn của bộ nhớ vật lý thì hệ điều hành sẽ ném nó sang phần virtual memory (swap). Điều này sẽ ảnh hưởng nghiêm trọng tới hiệu năng của ứng dụng và việc chuyển qua lại giữa virtual memory và physical memory là một tiến trình tốn kém về mặt hiệu năng. Có một số option được thiết lập khi khởi tạo JVM để giới hạn phần dung lượng meta space, tuy nhiên, làm như vậy có thể gây ra lỗi out of memory.

Code cache: JVM có một trình biên dịch để biên dịch byte code và convert chúng sang ngôn ngữ máy. Để tối ưu cho JVM, trình JIT (Just in time) được ra đời, các khối code thường được truy cập sẽ được biên dịch sang ngôn ngữ máy bởi JIT và lưu trữ trong vùng code cache. Sau đó, phần này sẽ được trình biên dịch bỏ qua.

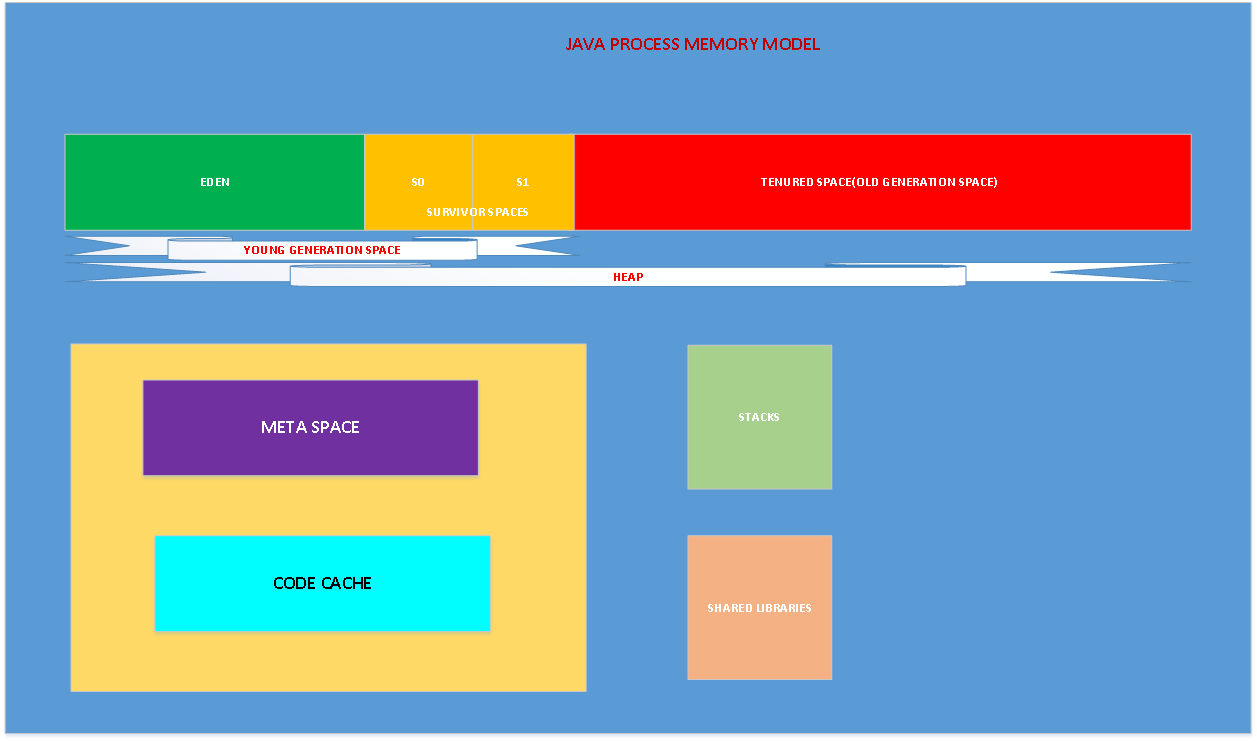

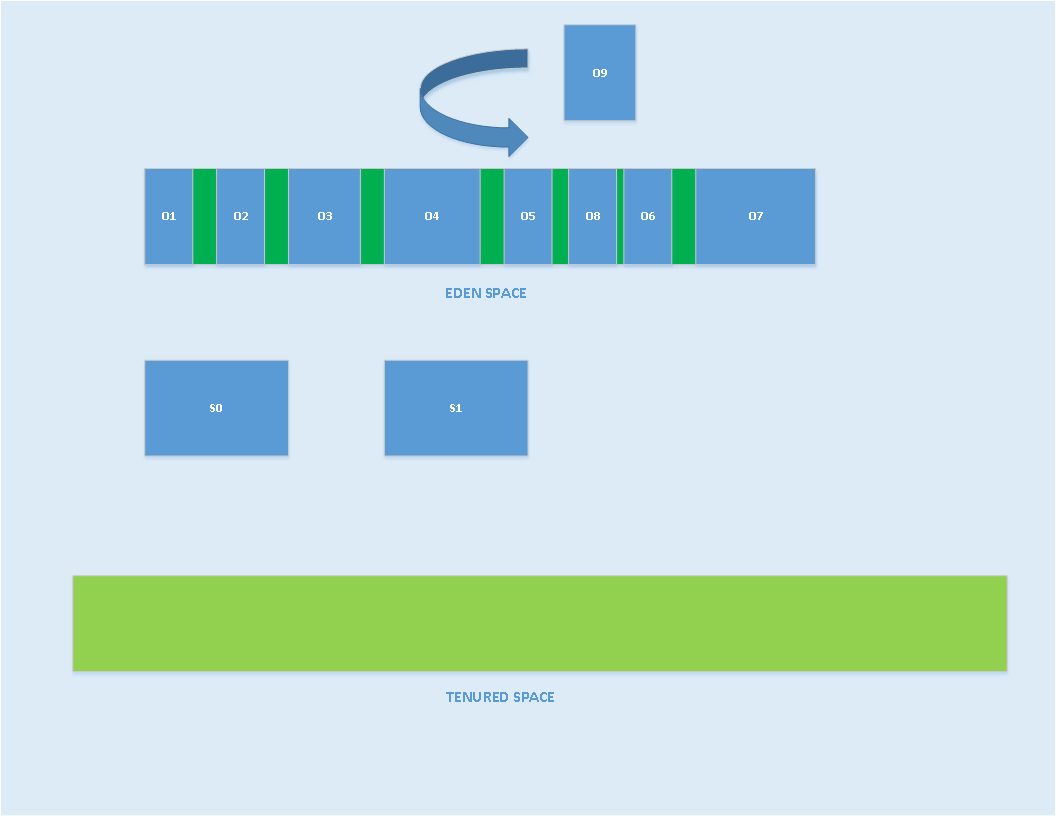

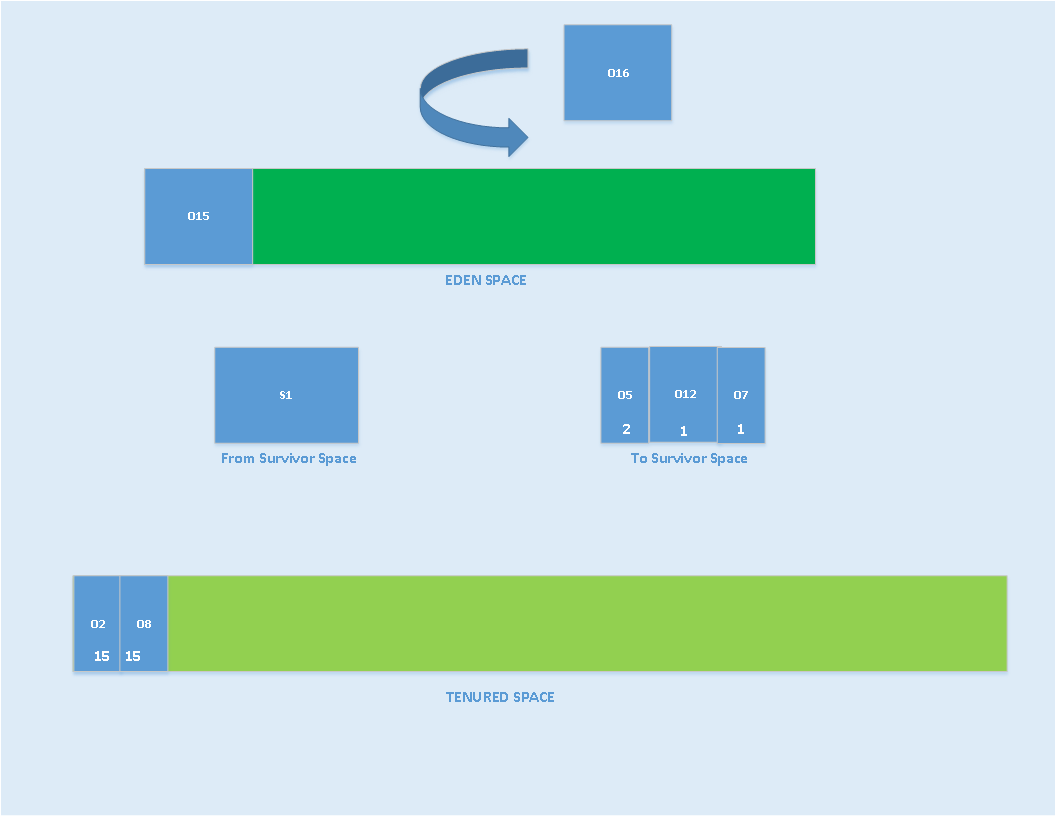

Bây giờ, chúng ta sẽ thảo luận về tiến trình garbage collection. JVM sử dụng các tiến trình riêng rẽ cho việc garbage collection (GC). Như đã đề cập tới ở trên, khi ứng dụng tạo các object, JVM sẽ cố lấy phần bộ nhớ cần thiết từ eden space. JVM thực hiện quá trình GC dưới dạng minor GC và major GC. Dưới đây là minh hoạ cho minor GC

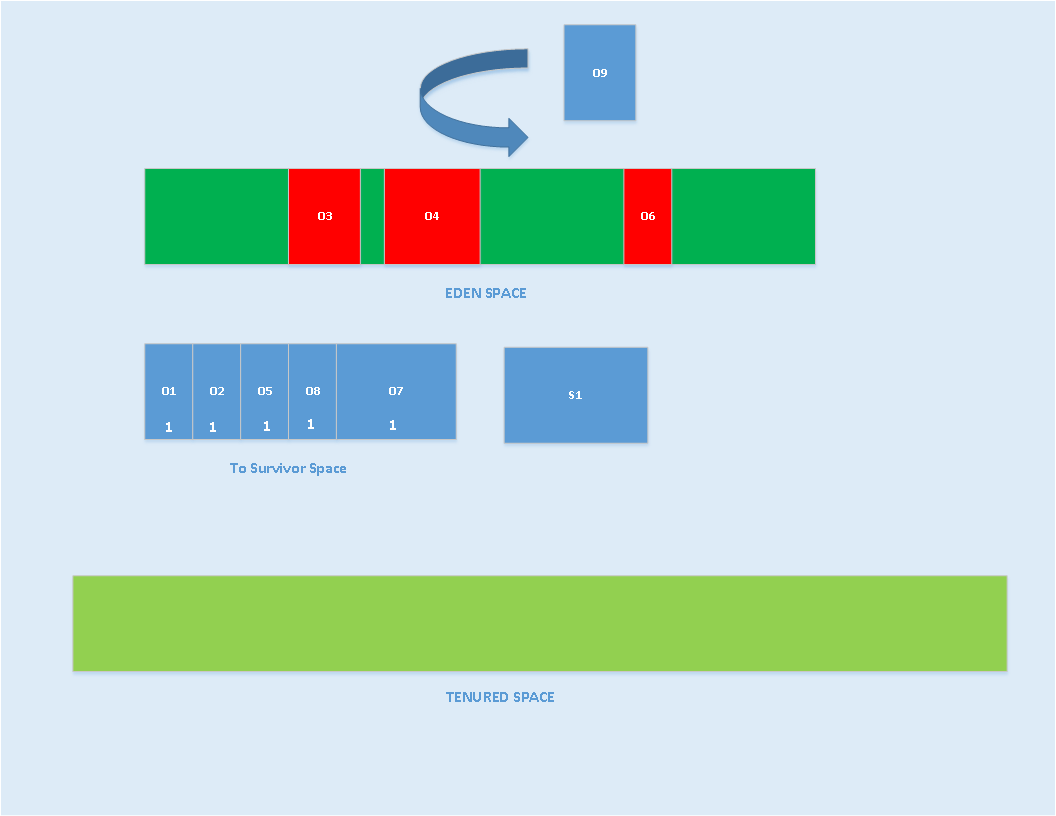

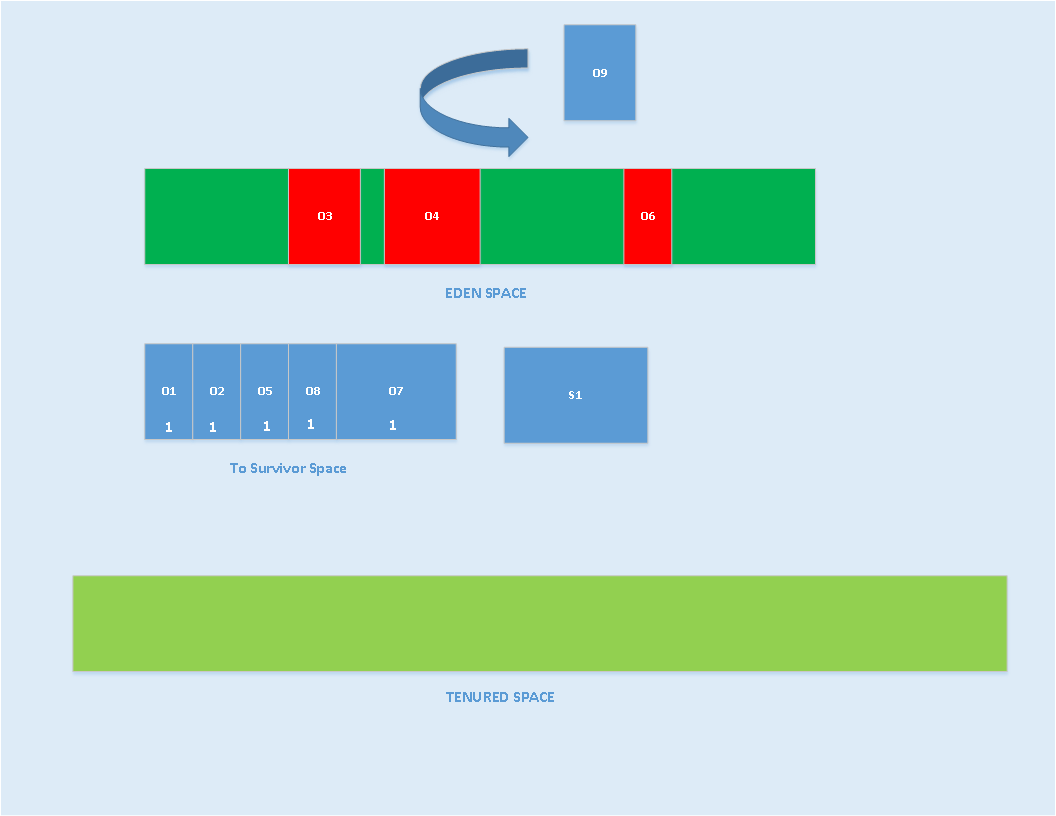

Khi khởi tạo, survivor space và tenured space rỗng. Khi JVM không thể lấy bộ nhớ từ eden space được nữa thì nó khởi động tiến trình minor GC. Trong khi minor GC, các object không thể sử dụng được nữa sẽ bị đánh dấu là collected. JVM sẽ chọn một trong 2 phần của survivor space làm “to space”, nó có thể là S0 hoặc S1. Ví dụ nó chọn S0 làm “to space”, JVM sẽ copy các object còn có thể sử dụng vào “to space” (S0) và tăng 1 con số gọi là Age của object đó lên 1, các object không nhét vào survivor space được sẽ bị nhét vào tenured space. Tiến trình này được gọi là “premature promation”. Ở hình bên dưới, tôi đã làm cho “to space” lớn hơn dung lượng được cấp phát, lưu ý rằng survivor không được tăng.

Trong hình trên, các object được đánh dấu màu đỏ có nghĩa rằng nó không còn sử dụng được nữa. Còn lại thuộc về GC roots, vẫn đang còn được sử dụng và sẽ không bị move đi bởi GC. GC sẽ ném phần màu đỏ đi và trả lại bộ nhớ trống cho eden space.

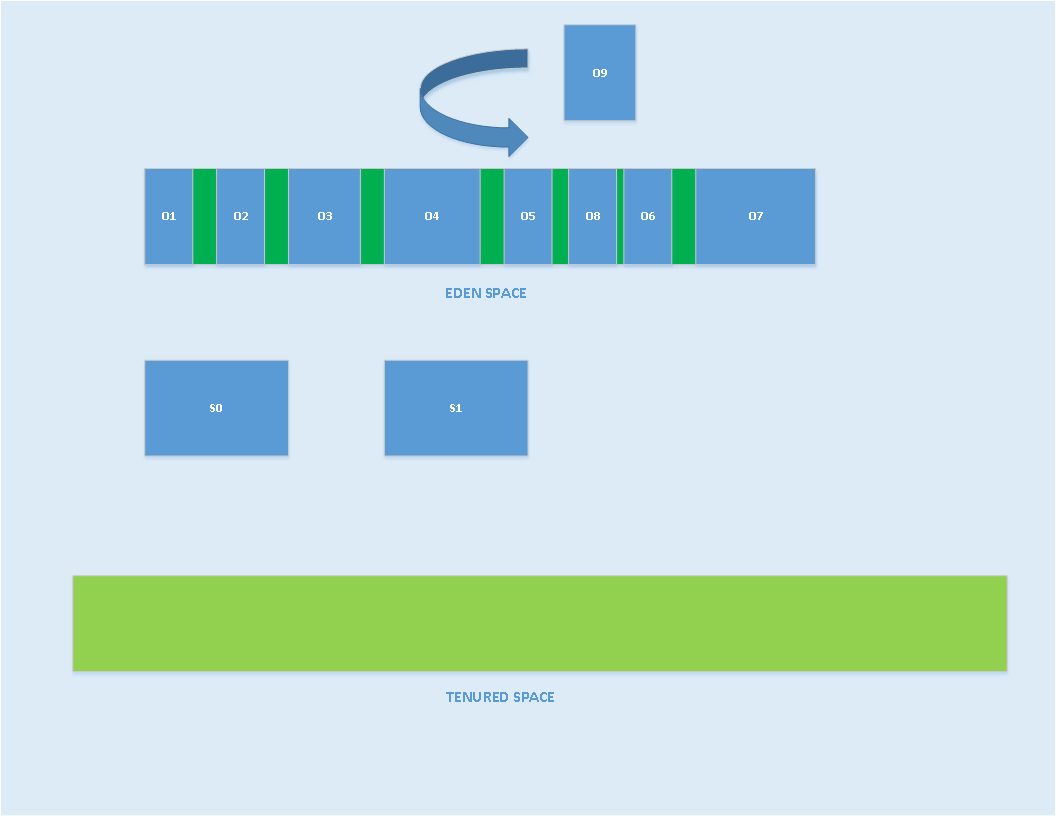

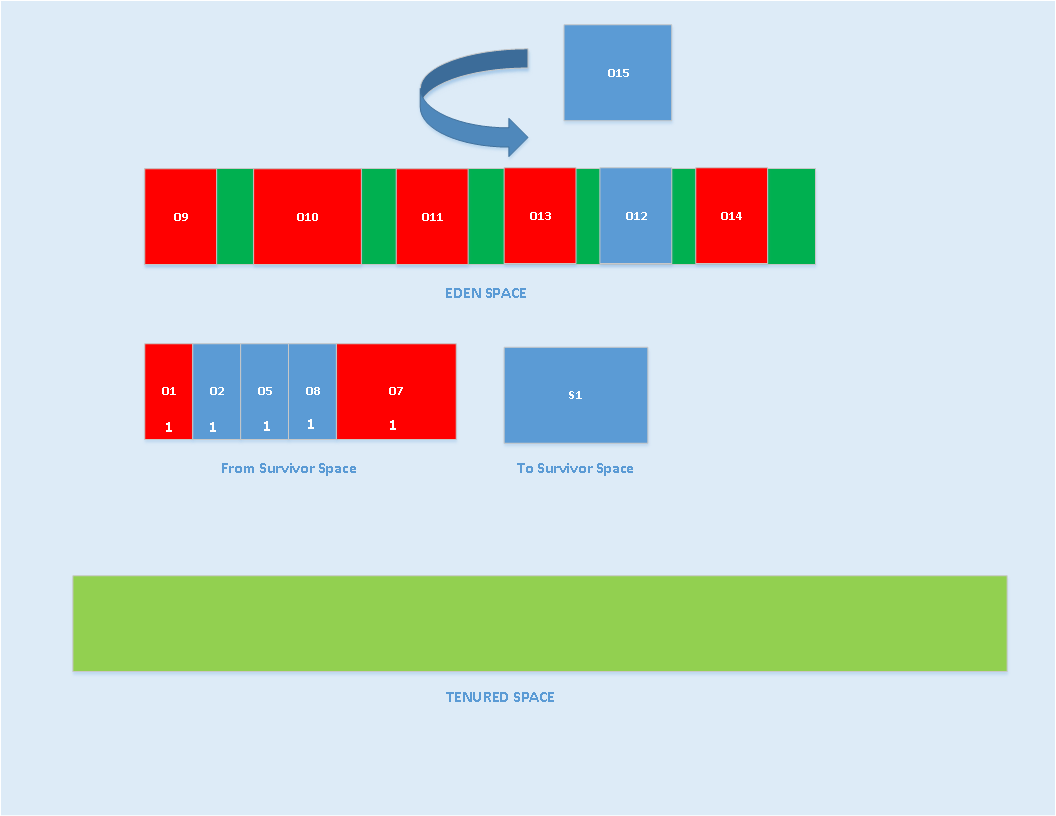

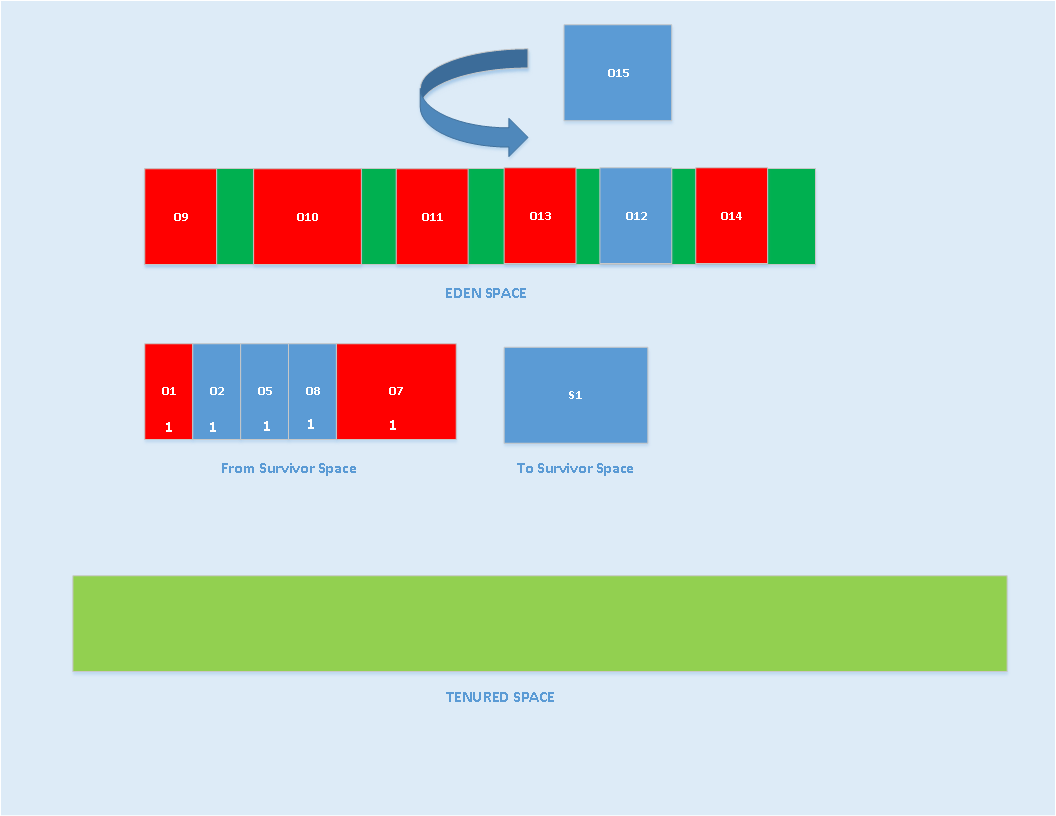

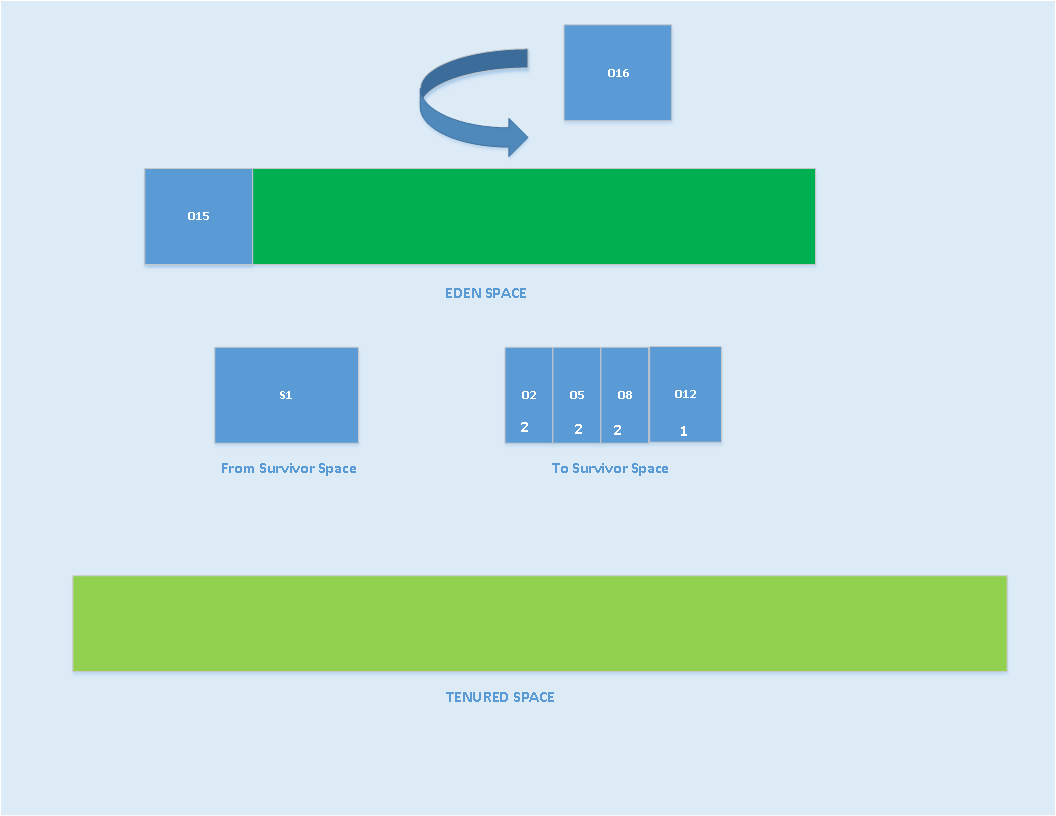

Đối với quá trình minor GC thứ 2, GC sẽ đánh dấu các object vô dụng từ eden space và “to space” S0, và copy GC roots sang survivor khác là S1, Age của các object sẽ được tăng lên tiếp.

Trong hình trên, object được đánh dấu với màu đỏ, sẽ bị GC copy từ eden vào survivor tới vùng survivor S1 và object được tăng thêm.

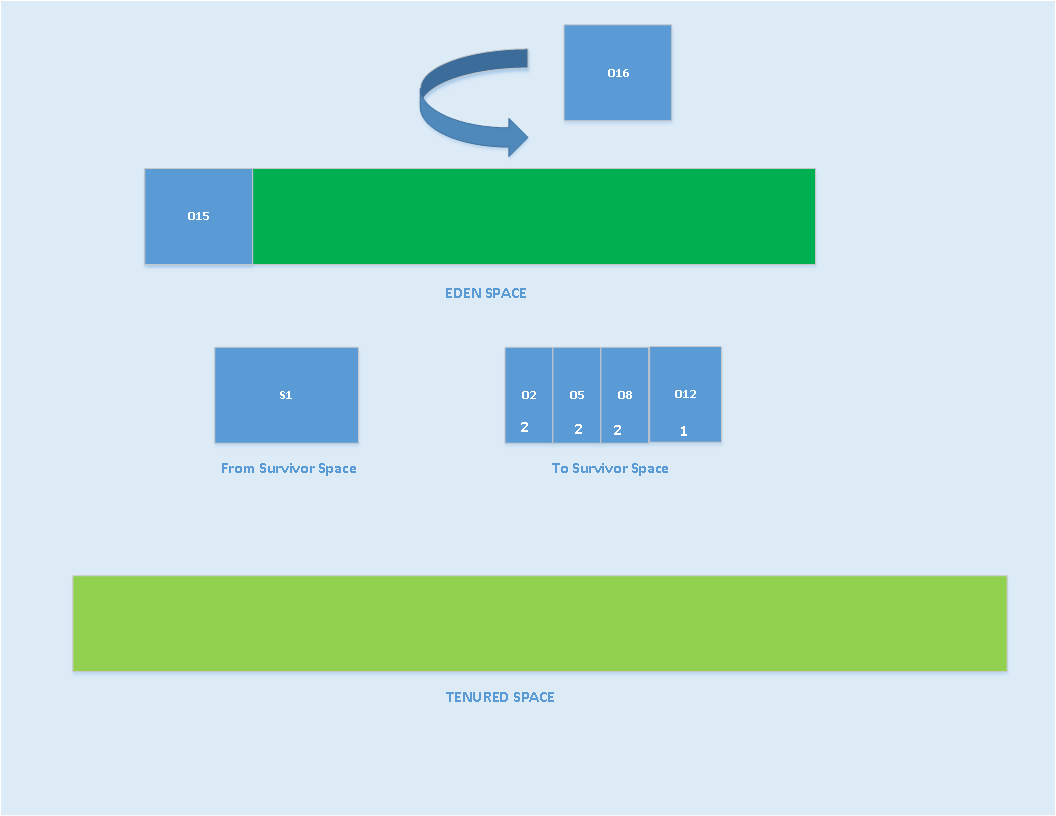

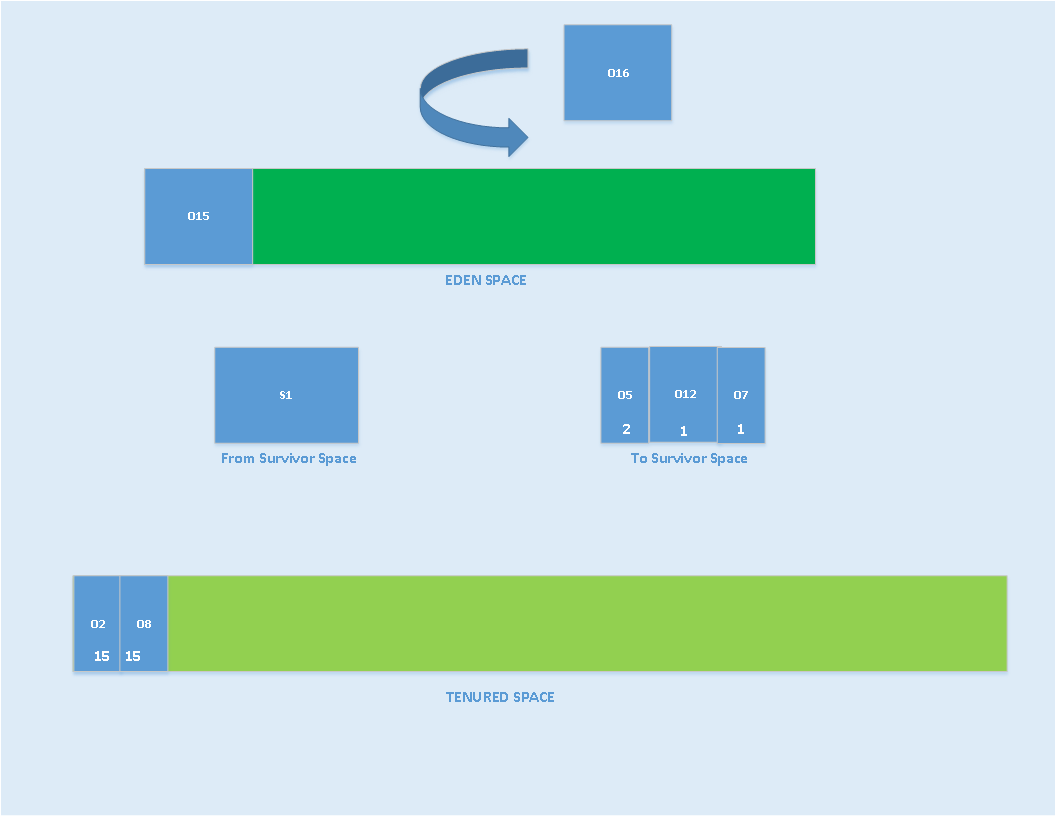

Tiến trình trên được lặp lại với mỗi minor GC, khi object được chạm tới số Age tối đa cho phép, nó sẽ bị ném sang tenured space.

Vì lẽ đó, JVM có 1 option gọi là MaxTenuringThreshold, để định nghĩa số Age tối đa của object. mặc định con số này là 15

Chung kết lại là minor GC sẽ thu hồi lại bộ nhớ từ Young Generation Space. Minor GC là một tiến trình “stop the world”. Thỉnh thoảng, ứng dụng bị dừng lại, nhưng không đánh kể. Minor GC có thể được chạy dưới dạng đơn luồng hoặc đa luồng, tuỳ vào GC collector được sử dụng.

Nếu minor GC được chạy vài lần, thì Tenured space sẽ bị đầy dần lên và phải cần thêm GC nữa. Khi đó, JVM khởi chạy major GC. đôi khi, có thể gọi tiến trình này là full GC.Nhưng, như 1 phần của full GC, JVM sẽ thu hồi phần bộ nhớ từ Meta space, nếu không có object nào trong heap, thì những class đã được load sẽ bị remove khỏi meta space.

Dưới đây là những trigger mà JVM sử dụng để gọi major GC:

- Nếu developer sử dụng hàm system.gc() hoặc Runtime.getRunTime().gc()

- Nếu JVM nhận thấy rằng không đủ bộ nhớ tenred space.

- Nếu khi thực hiện minor GC, JVM cảm thấy không thể lấy đủ bộ nhớ từ eden hoặc survivor space.

- Nếu có option MaxMetaspaceSize được đặt sẵn, và JVM không đủ memory để load class mới.